技術開発ニュース No.168

- ページ: 51

-

研 究 成 果

4

評価

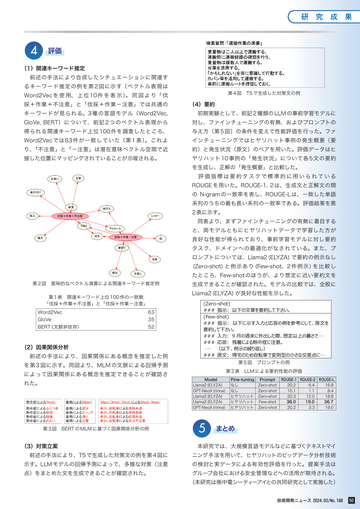

(1)関連キーワード推定

前述の手法により合成したシチュエーションに関連す

るキーワード推定の例を第 2 図に示す(ベクトル表現は

Word2Vec を 使 用、 上 位 10 件 を 表 示 )。 同 図 よ り「 伐

採+作業+不注意」と「伐採+作業-注意」では共通の

キーワードが見られる。3 種の⾔語モデル(Word2Vec,

第 4 図 T5 で生成した対策文の例

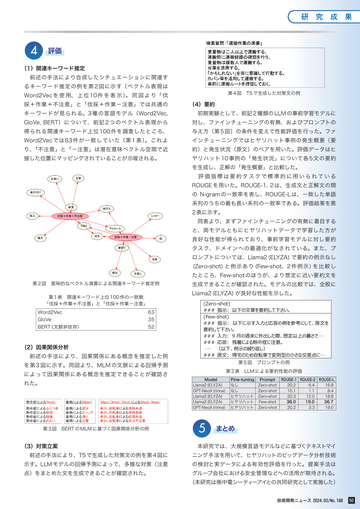

(4)要約

初期実験として、前記 2 種類の LLM の事前学習モデルに

GloVe, BERT)について、前記 2 つのベクトル表現から

対し、ファインチューニングの有無、およびプロンプトの

得られる関連キーワード上位 100 件を調査したところ、

与え方(第 5 図)の条件を変えて性能評価を行った。ファ

Word2Vec では 63 件が一致していた(第 1 表)。これよ

インチューニングではヒヤリハット事例の発生概要(要

り、「不注意」と「-注意」は潜在意味ベクトル空間で近

約)と発生状況(原文)のペアを用いた。評価データはヒ

接した位置にマッピングされていることが示唆される。

ヤリハット 10 事例の「発生状況」について各 5 文の要約

を生成し、正解の「発生概要」と比較した。

評価指標は要約タスクで標準的に用いられている

ROUGE を用いた。ROUGE-1, 2 は、生成文と正解文の間

の N-gram の一致率を表し、ROUGE-L は、一致した単語

系列のうちの最も長い系列の一致率である。評価結果を第

2 表に示す。

同表より、まずファインチューニングの有無に着目する

と、両モデルともにヒヤリハットデータで学習した方が

良好な性能が得られており、事前学習モデルに対し要約

タスク、ドメインへの最適化がなされている。また、プ

ロンプトについては、Llama2(ELYZA) で要約の例示なし

(Zero-shot) と例示あり (Few-shot、2 件例示 ) を比較し

第 2 図 意味的なベクトル演算による関連キーワード推定例

生成できることが確認された。モデルの比較では、全般に

Llama2(ELYZA) が良好な性能を示した。

第 1 表 関連キーワード上位 100 件の一致数

「伐採+作業+不注意」と「伐採+作業-注意」

Word2Vec

63

BERT(文脈非依存)

52

GloVe

たところ、Few-shot のほうが、より想定に近い要約文を

35

(2)因果関係分析

前述の手法により、因果関係にある概念を推定した例

(Zero-shot)

###

:

(Few-shot)

###

:

###

###

…

###

: 9

:

:

を第 3 図に示す。同図より、MLM の文脈による回帰予測

によって因果関係にある概念を推定できることが確認さ

れた。

第 3 図 BERT の MLM に基づく因果関係分析の例

(3)対策立案

…

第 5 図 プロンプトの例

…

第 2 表 LLM による要約性能の評価

Model

Llama2(ELYZA)

GPT-NeoX(rinna)

Llama2(ELYZA)

Llama2(ELYZA)

GPT-NeoX(rinna)

5

Fine-tuning Prompt

なし

Zero-shot

なし

Zero-shot

ヒヤリハット Zero-shot

ヒヤリハット Few-shot

ヒヤリハット Zero-shot

ROUGE-1 ROUGE-2 ROUGE-L

20.2

6.4

16.8

10.1

1.1

8.4

20.3

12.0

18.8

38.0

19.0

36.7

20.2

3.3

19.0

まとめ

本研究では、大規模⾔語モデルなどに基づくテキストマイ

前述の手法により、T5 で生成した対策文の例を第 4 図に

ニング手法を用いて、ヒヤリハットのビッグデータ分析技術

示す。LLM モデルの回帰予測によって、多様な対策(注意

の検討と実データによる有効性評価を行った。提案手法は

点)をまとめた文を生成できることが確認された。

グループ会社における安全管理などへの活用が期待される。

(本研究は㈱中電シーティーアイとの共同研究として実施した)

技術開発ニュース 2024.03/No.168

50

�

- ▲TOP